2021 г.

Правило пяти минут тридцать лет спустя и его влияние на иерархию хранения данных

Раджа Аппусвами, Рената Боровица-Гайич, Гетц Грефе, Анастасия Айламаки

Перевод: С.Д. Кузнецов

The Five-minute Rule Thirty Years Later and its Impact on the Storage Hierarchy

Raja Appuswamy, EPFL, Switzerland, Renata Borovica-Gajic, University of Melbourne, AU, Goetz Graefe, Google, Madison WI, USA, Anastasia Ailamaki, EPFL, Switzerland

Proc. of the International Workshop on Accelerating Analytics and Data Management Systems Using Modern Processor and Storage Architectures, ADMS@VLDB 2017, 2017, pp. 1-8

Communications of the ACM, November 2019, Vol. 62, No. 11, pp. 114-120

Аннотация

В 1987 году Джим Грей (Jim Gray) и Джанфранко Путцолу (Gianfranco Putzolu) предложили правило пяти минут для буферизации данных в основной памяти с целью сокращения числа дисковых операций ввода-вывода при имевшихся тогда характеристиках цены и производительности DRAM и HDD. Правило пяти минут получило широкое признание в качестве эмпирического метода инженерии данных и дважды пересматривалось: один раз в 1997 году, чтобы учесть изменения в технологии и ценовых соотношениях HDD и DRAM, и затем в 2007 году для учета влияния твердотельных накопителей на основе флэш-памяти NAND на двухуровневую иерархию DRAM-дисковая память.

В этой статье мы возвращаемся к правилу пяти минут спустя три десятилетия со времени его введения. Во-первых, мы представляем изменения, которые доминировали в области аппаратных средств хранения данных в последнее десятилетие, и пересчитываем интервалы безубыточности для сегодняшней многоуровневой иерархии хранения данных. Затем мы представляем последние тенденции к прогнозированию свойств аппаратуры, появление которой ожидается в следующем десятилетии, и используем правило пяти минут для предсказания последствий этих прогнозов для проектирования систем управления данными.

1. Введение

На разработку компьютерных систем вообще и систем управления данными в частности всегда влияли изменения в аппаратуре хранения данных. В 1980-е гг. в подсистемах хранения данных СУБД использовалась двухуровневая иерархия хранения, в которой на первом уровне использовалась DRAM, а на втором – накопители на жестких магнитных дисках (Hard Disk Drives, HDD). Для сглаживания существенного различия между скоростями работы процессоров и HDD основная память использовалась для кэширования часто используемых данных, хранящихся на дисках. Однако поскольку объем основной памяти всегда составлял только малую долю размера доступной дисковой памяти, возникал очевидный вопрос: в каких случаях экономически целесообразно кэшировать элемент данных в основной памяти, а не обращаться сразу к дисковому хранилищу данных?

В 1987 году Джим Грей (Jim Gray) и Джанфранко Путцолу (Gianfranco Putzolu) предложили знаменитое теперь правило пяти минут, обеспечивающее точный ответ на этот вопрос: в основной памяти следует удерживать те страницы, доступ к которым требуется каждые пять минут [9]. Они получили эту цифру путем вычисления размера интервала безубыточности, в пределах которого стоимость удержания страницы в основной памяти соразмерна со стоимостью выполнения операции ввода/вывода для чтения страниц с диска. Используя тогдашние характеристики цены и производительности DRAM и HDD аппаратных средств компании Tandem, они вычислили, что размер интервала безубыточности составляет 400 секунд и округлили его в меньшую сторону до пяти минут.

Если бы все технологии и стоимости в иерархии хранения данных изменялись с одной и той же скоростью, правило пяти минут никогда бы не изменилось. Однако различные технологии хранения данных и даже различные аспекты конкретных технологий (например, емкость, величина задержки и пропускная способность) изменяются с разной скоростью. Эти изменения в технологии и экономические факторы прямо влияют на правило пяти минут для иерархии хранения DRAM-HDD, поскольку размер интервала безубыточности может значительно изменяться при смене поколений аппаратуры хранения данных. Кроме того, изменяется и общий ландшафт аппаратных средств хранения данных, поскольку новые средства хранения данных, такие как флэш-память NAND, с существенно другими характеристиками стоимости и производительности представляют альтернативу HDD в качестве первичной среды хранения данных. Это приводит к тому, что исходное правило для иерархии DRAM-HDD дополняется новыми правилами, основанными на том, как новый носитель данных интегрируется в традиционную двухуровневую иерархию хранения. Поэтому с момента его введения правило пяти минут пересматривалось дважды, один раз в десять лет, с учетом новых показателей в первом случае [8] и с учетом флэш-памяти во втором случае [6].

В сегодняшних подсистемах хранения данных используются иерархии хранения, которые могут основываться на девяти разновидностях носителей данных (NVDIMM, 3D XPoint, флэш-память в формате DIMM (Memory channel flash), флэш-устройства с подключением по шине PCIe (PCIe flash), SSD с интерфейсом SATA (SATA SSD), HDD с 15 тысяч оборотов в минуту (15k RPM HDD), HDD с 7 тысячами оборотов в минуту (7k RPM HDD), устройства хранения «холодных» данных на основе массивов мало используемых дисков (MAID-based Cold storage devices), ленты) со значительно разными характеристиками стоимости, производительности и надежности, группируемыми по четырем разным уровням (производительность, емкость, архивирование и резервное копирование). Поэтому в данной статье мы пересматриваем правило пяти минут для современной многоуровневой иерархии. Таким образом, в этой статье мы возвращаемся к правилу пяти минут для современной многоуровневой иерархии хранения. При этом мы представляем изменения в иерархии хранилищ за последнее десятилетие, выделяем тенденции, которые будут формировать иерархию хранилищ в ближайшем будущем, и используем рекомендации, содержащиеся в правиле пяти минут, для определения предстоящих изменений в конструкции механизмов управления данными на основе нового оборудования.

Результаты нашего анализа заключаются в следующем.

- Наш анализ показывает увеличивающийся разрыв между уровнем производительности на основе DRAM или SSD и уровнем емкости на основе HDD. То, что раньше было правилом пяти минут для DRAM и HDD, теперь превратилось в правило четырех часов, а интервал безубыточности для случая SSD-HDD составляет один день. Это говорит о том, что все критически важные для производительности данные скоро, если не прямо сейчас, будут располагаться только в DRAM и на SSD, а жесткий диск будет считаться средой хранения с высокой плотностью записи для редко используемых данных. Это также означает, что производители жестких дисков и твердотельных накопителей должны ориентироваться на разные уровни и аспекты оптимизации, а именно на число операций ввода-вывода в секунду для уровня производительности в случае твердотельных накопителей и стоимость в расчете на гигабайт данных для уровня емкости в случае жестких дисков.

- На уровне емкости по мере того, как HDD и лента превращаются в носители бесконечной емкости, разница между ними в отношении таких показателей, как $/TBScan (размер арендной платы за терабайт носителя на время его последовательного сканирования), также сокращается. С учетом популярности пакетной аналитики и присущего ей интенсивного характер сканирования, наш анализ показывает, что было бы целесообразно и даже экономически выгодно использовать полуоперативные (nearline) и третичные устройства хранения данных, которые сегодня используются только на уровне архивирования, как часть уровня емкости для обслуживания приложений пакетной аналитики.

Основная часть этой статьи организована следующим образом. В разд. 2 представлен обзор многоуровневого хранилища, используемого в современных подсистемах хранения данных СУБД. Затем, в разд. 3, мы еще раз возвращаемся к правилу пяти минут через три десятилетия с момента его введения, вычисляем интервалы безубыточности с использованием характеристик цена/производительность, типичных для современного оборудования хранения данных, и сравниваем интервалы с теми, которые вычислялись за последние три итерации правила пяти минут. После этого мы анализируем влияние на правило пяти минут появляющегося оборудования для хранения данных, рассматривая сначала уровень производительности в разд. 4, а затем уровень емкости в разд. 5. В каждом случае мы кратко описываем последние тенденции в аппаратных технологиях, вычисляем интервалы безубыточности для нового оборудования и обсуждаем последствия нашего анализа для соответствующего уровня хранения.

2. История вопроса: уровни хранения данных

В подсистемах управления данными корпоративных систем баз данных уже давно используется многоуровневое хранение данных для сокращения капитальных и эксплуатационных расходов. Традиционно в подсистемах хранения данных использовалась двухуровневая иерархия хранения. Оперативный (онлайновый) уровень, основанный на корпоративных устройствах хранения данных на жестких дисках (HDD), обеспечивает доступ к данным с малой задержкой (миллисекунды). Уровень резервного копирования, основанный на офлайновых ленточных картриджах или оптических дисках, напротив, обеспечивает недорогое хранилище с высокой задержкой доступа (часы) для хранения резервных копий, которые используются для восстановления базы данных только при редких сбоях.

По мере роста популярности баз данных стала важной потребность в сокращении времени восстановления после сбоя. Кроме того, поскольку нормативные требования вынуждали предприятия поддерживать долгосрочные архивы данных, офлайновый характер уровня резервного копирования оказался слишком медленным как для сохранения, так и для извлечения редко используемых архивных данных. Это привело к появлению нового уровня архивирования, основанного на полуоперативных устройствах хранения данных, таких как виртуальные ленточные библиотеки (VTL), которые могут сохранять и извлекать данные без вмешательства человека за считанные минуты.

Примерно в начале 2000-х годов привлекательной альтернативой для хранения данных стали твердотельные запоминающие устройства (SSD) на основе флэш-памяти NAND из-за их способности выполнять на порядки большее число произвольных операций ввода-вывода в секунду (Input/Output Operations Per Second, IOPS) по сравнению с HDD. SSD оказались идеальной «золотой серединой» между DRAM и HDD с точки зрения цены и производительности. Энергопотребление SSD также было существенно ниже, чем у HDD. Однако первому поколению SSD на основе флэш-памяти были свойственных две проблемы: низкий срок службы из-за износа схем NAND и высокая стоимость в расчете на Гб по сравнению с HDD. Поскольку поставщики твердотельных накопителей быстро снизили стоимость в расчете на Гб, используя, в частности, многоуровневые ячейки и трехмерную компоновку (3D stacking), и увеличили срок службы за счет эффективного выравнивания износа (wear leveling) и увеличения числа запасных ячеек (over-provisioning), традиционный онлайн-уровень на основе жестких дисков был разделен на два подуровня, а именно, уровень производительности на основе на RAM или SSD, и уровень емкости на основе HDD.

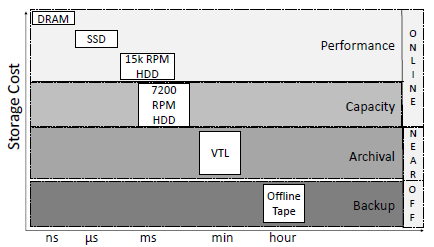

Рис. 1. Уровни хранения данных в корпоративных базах данных

Таким образом, сегодня в корпоративных базах данных обычно используется четырехуровневая иерархия хранения, как показано на рис. 1. Уровень производительности на основе DRAM или SSD используется для размещения данных, к которым обращаются приложения, критичные к задержкам, такие как аналитика данных в реальном времени или крупномасштабная обработка транзакции. Уровень емкости на основе жестких дисков используется для размещения данных, к которым обращаются приложения, не чувствительные к задержкам, такие как пакетная аналитика. Уровень полуоперативного архивирования на основе VTL и уровень офлайнового резервного копирования на основе лент не используются для «оперативной» обработки запросов, а применяются для хранения данных, к которым будут очень редко обращаться во время аварийного восстановления или аудита безопасности. Подсистемы хранения данных классифицируют данные на основе различных характеристик (таких как специфика целевого приложения или частота обращений), чтобы определить идеальный уровень хранения. После этого используются менеджеры иерархического хранения данных (Hierarchical Storage Managers, HSM) для автоматического управления миграцией данных между оперативным, полуоперативным и офлайновым уровнями хранения данных [14].

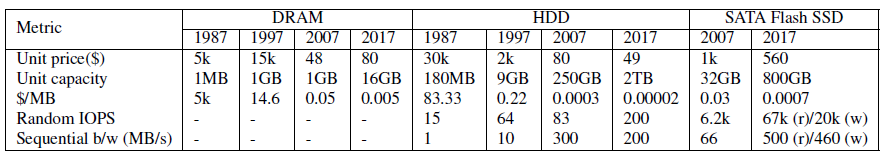

В табл. 1 показаны цена, емкость и производительность DRAM, HDD и SSD на основе флэш-памяти NAND за несколько лет. Значения, представленные для 1987, 1997 и 2007 годов, взяты непосредственно из статей о правиле пяти минут, опубликованных в соответствующие годы [6, 8, 9]. Значения за 2017 год типичны для современных технологий. Мы получили эти значения на основе компонентов, перечисленных в спецификации сервера из недавнего отчета TPC-C [30]. В таблице приведены значения производительности, полученные из спецификаций поставщиков, и цены, указанные на сайте www.newegg.com 1 июня 2017 г.

Табл. 1. Эволюция свойств DRAM, HDD и Flash SSD

Хотя эти значения являются репрезентативными для характеристик цена/производительность устройств в соответствующих категориях, они ни в коем случае не являются универсально точными. Кроме того, за последние несколько лет поставщики жестких дисков и твердотельных накопителей также начали оптимизировать устройства хранения для различных целей; при этом производители HDD уделяют особое внимание емкости, а производители SSD – производительности. Это привело к появлению нового поколения HDD корпоративного уровня с высокой плотностью записи, основанных на новых методах записи, таких как технология черепичной магнитной записи (Shingled Magnetic Recording, SMR), и высокопроизводительных SSD с интерфейсом PCIe, которые обеспечивают на порядок лучшую производительность, чем их аналоги с интерфейсом SATA. Мы обсудим, как эти изменения повлияют на правило пяти минут, в разд. 4 и разд. 5. Мы предлагаем читателям самостоятельно пересчитать соответствующие формулы для других сред, представляющих интерес.

3. Пересмотр правила пяти минут

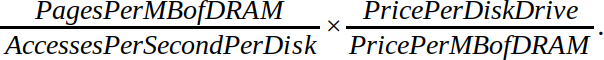

Исходное правило пяти минут позволяет найти компромисс между стоимостью DRAM и стоимостью дисковых операций ввода-вывода. Учитывая, что кэширование страниц в основной памяти сокращает число дисковых операций ввода-вывода, правило пяти минут предоставляет формулу для прогнозирования размера оптимального интервала безубыточности – временного окна, в течение которого должен быть произведено повторное обращение к данным, чтобы они соответствовали требованиям кэширования в основной памяти. Интервал вычисляется следующим образом:

Первый сомножитель в этой формуле назывался технологическим сомножителем, поскольку и AccessesPerSecondPerDisk, и PagesPerMBofDRAM (или размер страницы) определяются развитием аппаратных технологий. Второе соотношение, напротив, называется экономическим сомножителем, поскольку ценообразование определяется рядом факторов, а не просто уровнем аппаратных технологий.

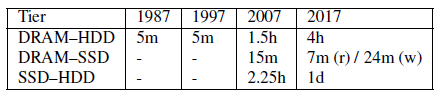

Табл. 2. Изменение размера интервала безубыточности за четыре десятилетия на основе соответствующих значений цены, производительности и размера страницы

В табл. 2 представлены размеры интервала безубыточности за четыре десятилетия. Размеры интервала в 1987, 1997 и 2007 годах взяты из исходной статьи [9] и двух последующих статей, опубликованных через десять [8] и двадцать лет [6] после публикации исходной статьи. Значения 2017 г. основаны на показателях, указанных в табл. 1.

DRAM-HDD. Сначала рассмотрим случай DRAM-HDD. В 1987 году типичный размер страницы, используемой в подсистемах хранения данных, составлял 1 Кб. Для страниц размером 1 Кб интервал безубыточности составлял 400 секунд, примерно пять минут, что и дало название этому знаменитому правилу.

Когда исследование было повторено в 1997 году, технологический сомножитель уменьшился в десять раз из-за увеличения числа дисковых операций ввода-вывода в секунду и связанного с этим роста размера страницы с 1 Кб до 8 Кб. Экономический сомножитель увеличился в десять раз из-за падения цен на DRAM и HDD. В результате эти два сомножителя уравновешивали друг друга, и получился интервал безубыточности в 266 секунд, т.е. правило пяти минут для страниц размером 8 Кб осталось неизменным. Однако для страниц размером 4 Кб размер интервала оказался равным девяти минутам, в пять раз больше интервала 1987 года, равного 100 секундам.

В период с 1997 по 2007 год стоимость DRAM и HDD продолжала снижаться, в результате чего экономический сомножитель увеличился со 133 (2 тыс. долларов/15 долларов) до 1700 (80 долларов/0,047 доллара). Однако улучшение показателей произвольного дискового ввода-вывода не отставало. В результате для страниц размером 4 Кб интервал безубыточности увеличился в 10 раз с девяти минут до 1,5 часов. В 2007 году было установлено, что старое правило пяти минут для DRAM и HDD может применяться для страницы размером 64 Кб.

За последнее десятилетие экономический сомножитель еще больше увеличился с 1700 до 10 000 (49 долл./0,005 долл.) из-за дальнейшего снижения стоимости 1 ГБ DRAM и HDD. Однако производительность жестких дисков увеличилась только в 2,5 раза (200/83), что привело к гораздо меньшему уменьшению технологического сомножителя. В результате сегодня интервал безубыточности для случая DRAM-HDD при размере страницы 4 Кб составляет четыре часа. Правило пяти минут действует сегодня для страниц размером 512 Кб.

DRAM-SSD. Как отмечалось в разд. 2, SSD все чаще используются в качестве предпочтительной среды хранения данных на уровне производительности, критичном к задержкам. Таким образом, правило пяти минут можно использовать для вычисления интервала безубыточности для сценария, когда DRAM используется для кэширования данных, хранящихся на SSD. В табл. 2 показаны размеры интервала в 2007 году, когда твердотельные накопители еще находились на начальных этапах внедрения, и сегодня, на основе характеристик цены и производительности SSD, перечисленных в табл. 1. Заметим, что мы показываем два интервала, по отдельности для IOPS чтения и записи.

Мы видим, что интервал уменьшился с 15 до семи минут, если принимать во внимание IOPS по чтению страниц в 4 Кб. Это резко контрастирует со случаем DRAM-HDD, где интервал увеличился в 2,7 раза с 1,5 часов до четырех часов. Как и в случае DRAM-HDD, в случае DRAM-SSD основное влияние на экономический сомножитель оказывает снижение стоимости DRAM. Однако, в отличие от 2,5-кратного увеличения IOPS для HDD, для SSD удалось добиться впечатляющего 11-кратного увеличения IOPS (67k/6,2k). Таким образом, для SSD увеличение экономического сомножителя было перекрыто уменьшением технологического сомножителя, что привело к сокращению интервала.

SSD-HDD. Поскольку SSD могут также использоваться в качестве кэша для HDD, те же формулы можно использовать для оценки интервала безубыточности для настройки иерархии SSD-HDD. Глядя на табл. 2, мы видим, что интервал безубыточности для этого случая увеличился в 10 раз с 2,25 часа в 2007 году до одних суток в 2017 году. Интервал для SSD-HDD в шесть раз длиннее, чем у и без того длинного интервала DRAM-HDD (одни сутки/четыре часа). Чтобы правило пяти минут действовало в случае SSD-HDD, размер страницы, используемой для доступа к жесткому диску, сегодня должен составлять 1 Мб.

Следствия. У этих результатов имеются три важных следствия. Во-первых, время повторной загрузки данных в DRAM в 2007 году при использовании HDD на втором уровне иерархии хранения данных было в шесть раз больше, чем при использовании SSD (1,5 часа/15 минут). В 2017 году этот разрыв увеличился до 34 (4 часа/7 минут). Таким образом, в системах, настраиваемых с учетом экономических соображений, следует заменить HDD на SSD, поскольку это не только повысит производительность, но и уменьшит требуемый объем DRAM, поскольку для достижения нужной производительности потребуется кэшировать меньшую часть данных.

Во-вторых, при наличии четырехчасового интервала для DRAM-HDD и суточного интервала для SSD-HDD следует хранить все активные данные на уровне производительности на основе DRAM или SSD и переназначить уровень емкости на основе HDD на хранение только редко используемых данных.

В-третьих, требование больших размеров страниц в 512 Кб и 1 Мб для соблюдения правила пяти минут в случаях DRAM-HDD и SSD-HDD отчетливо демонстрирует, что IOPS для произвольных операций возрастает гораздо медленнее последовательной пропускной способности HDD. Это говорит о том, что HDD следует преимущественно рассматривать как устройство последовательного доступа к данным, передаваемым крупными порциями. Это резко контрастирует с SSD, где сокращающийся интервал безубыточности DRAM-SSD ясно показывает, что современные SSD оптимизированы для случайного доступа к данным с малой задержкой.

Растущий разрыв между уровнями производительности и емкости также означает, что поставщики SSD и HDD должны преследовать разные цели оптимизации: производители SSD оптимизируют производительность, а поставщики HDD – затраты. В следующих двух разделах мы опишем изменения на уровнях и производительности, и емкости, которые указывают на то, что такие целевые оптимизации действительно выполняются.

4. Правило пяти минут и уровень производительности

За последние несколько лет в области аппаратных средств хранения данных, используемых для размещения данных на уровне производительности (DRAM и SSD), произошло несколько изменений. Кроме того, на рынок систем хранения данных начинает проникать новое оборудование, основанное на технологиях энергонезависимой памяти, отличных от флэш-памяти NAND, например, Intel 3D XPoint. В этом разделе мы представим обзор этих тенденций в области высокопроизводительных систем хранения данных и воспользуемся методологией правила пяти минут, чтобы пересмотреть альтернативы проектирования систем в контексте появляющегося оборудования.

4.1 Тенденции в области твердотельных устройств хранения данных

Флэш-память NAND. У твердотельных хранилищ данных имеется давняя история, начавшаяся задолго до того, как флэш-память NAND стала доминирующим носителем. Когда в начале 2000-х годов была представлена флэш-память NAND, доминирующей формой корпоративных твердотельных хранилищ являлись твердотельные накопители на основе оперативной памяти. К середине первого десятилетия 2000-х производители флэш-SSD решили проблемы производительности и надежности с использованием технологии флэш-памяти NAND, а твердотельные накопители с интерфейсом SATA начали приобретать широкую популярность в качестве корпоративных ускорителей.

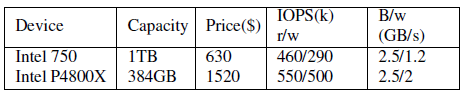

Табл. 3. Показатели цены/производительности для твердотельного накопителя Intel 750 PCIe на базе NAND и твердотельного накопителя Intel Optane P4800X PCIe на базе 3D-XPoint

В конце первого десятилетия 2000-х компании Fusion-IO и Violin представили новое поколение флэш-SSD с интерфейсом PCIe, которые могли обеспечивать на один-два порядка более высокую пропускную способность, чем их аналоги с SATA. С тех пор быстрое увеличение емкости, снижение цен и новые интерфейсы с низкими накладными расходами, такие как NVMe, привели к тому, что флэш-накопители SSD с интерфейсом PCIe вытеснили свои аналоги с SATA в качестве предпочтительных ускорителей серверов. В табл. 3 (первая строка) показаны характеристики цена/производительность типичного современного PCIe SSD. Сравнивая это с табл. 1, мы видим, что PCIe SSD обеспечивает в пять раз больше IOPS для операции чтения, в 12 раз больше IOPS для записи и в пять раз более высокую пропускную способность для последовательного доступа, чем его аналог с интерфейсом SATA.

NVDIMM. По мере того как поставщики SSD продолжали улучшать пропускную способность и емкость своих устройств, узкое место в подсистеме хранения данных сместилось с самого устройства на шину PCIe, которая используется для взаимодействия с SSD. Поэтому в последние несколько лет флэш-память NAND снова начала мигрировать от устройств хранения, которые связаны через шину PCIe с высокой задержкой (десятки мкс) и ограниченной полосой пропускания (десятки Гб/сек), на устройства постоянной памяти (Persistent Memory, PM). которые подключаются через шину основной памяти с малой задержкой и высокой пропускной способностью, используемую сегодня для подключения DRAM. В настоящее время в устройствах PM используется комбинация DRAM и флэш-накопителей, упакованных вместе в виде модуля памяти с двухрядным расположением выводов (Dual Inline Memory Module, DIMM) – стандартного форм-фактора, используемого для DRAM. Поэтому эти устройства также называются энергонезависимыми модулями DIMM (Non-Volatile DIMM, NVDIMM).

Работа по стандартизации идет полным ходом, поскольку SNIA (Storage Networking Industry Association, некоммерческая международная организация, занимающаяся разработкой стандартов и образовательных программ для развития технологий хранения и информационных технологий) и JEDEC (Joint Electron Tube Engineering Council, мировой лидер в разработке открытых стандартов для индустрии микроэлектроники) определили два типа модулей NVDIMM, а именно NVDIMM-N, NV-DIMM-F, которые уже сегодня доступны от нескольких поставщиков оборудования. NVDIMM-F – это модуль памяти DIMM, который содержит только флэш-память и по большинству показателей аналогичен PCIe SSD за исключением шины, используемой для взаимодействия с устройством (шина памяти вместо PCIe). Таким образом, устройства NVDIMM-F имеют блочную адресацию и обеспечивают меньшую задержку доступа, чем PCIe SSD из-за отсутствия накладных расходов PCIe, но все же NVDIMM-F значительно медленнее, чем DRAM. Примером устройства NVDIMM-F является Memory1 от Diablo Technologies [29]. NVDIMM-N, напротив, полностью скрывает SSD на основе флэш-памяти от стека программного обеспечения. Во время нормальной работы используется только во время перерыва в подаче электроэнергии в качестве резервного носителя для сохранения и восстановления содержимого DRAM. Хотя характеристики производительности NVDIMM-N аналогичны характеристикам DRAM, ограничения энергопотребления DRAM и проблемы с упаковкой приводят к емкости в масштабах гигабайтов. Примером устройства NVDIMM-N является 8GB NVDIMM от Micron [17], в которым объединяются DRAM, флэш-память и суперконденсатор.

3D Xpoint. Сегодня модули NVDIMM все еще являются нишевыми ускорителями по сравнению с PCIe SSD из-за высокой стоимости в расчете на Гб и относительно небольшой емкости. В отличие от этих технологий, NVDIMM, которые основываются на флеш-памяти NAND, Intel 3D XPoint, – это новый носитель данных, имеющий, как утверждается, большую долговечность, более высокую пропускную способность и меньшую задержку, чем флеш-память NAND. Intel Optane DC P4800X – это недавно анонсированный PCIe SSD на основе технологии 3D XPoint [11]. В табл. 3 (вторая строка) приведены характеристики этого SSD. Стоимость 3D XPoint за 1 Гб сегодня намного выше, чем у флэш-памяти NAND, так как технология является новой и еще не зрелой. Однако, по сравнению с флеш-памятью, NAND 3D XPoint не демонстрирует больших различий между пропускной способностью чтения и записи. Предварительные исследования также показали, что 3D XPoint обеспечивает предсказуемые задержки доступа для чтения/записи, которые намного ниже, чем у некоторых современных флеш-устройств NAND, даже при большой нагрузке [27].

4.2 Интервал безубыточности и следствия

С учетом отмеченных изменений стоит пересмотреть правило пяти минут для этих новых устройств хранения данных на уровне производительности. Когда мы применяем формулу правила пяти минут с использованием показателей цена/производительность, приведенных в табл. 3, мы получаем интервал безубыточности в 41 секунду/одну минуту для операций чтения/записи для случая SSD-накопителя DRAM-NAND Flash PCIe SSD и 47 секунд/52 секунды для случая DRAM-3D XPoint.

Сравнивая эти результаты с табл. 2, мы видим две важные тенденции. Во-первых, интервал безубыточности становится короче, если на втором уровне вместо SATA SSD используются PCIe SSD или новые технологии PM. Это можно объяснить уменьшением технологического сомножителя, вызванным увеличением IOPS для случайных операций. По мере миграции устройств на основе флэш-памяти NAND и 3D XPoint с PCIe на шину памяти их пропускная способность будет увеличиваться, что приведет к пропорциональному сокращению интервала безубыточности. Во-вторых, в традиционных SATA SSD интервал, основанный на IOPS, для операций чтения, в четыре раза меньше, чем интервал на основе IOPS для операций записи. Однако эта разница намного меньше при использовании современных PCIe SSD на основе 3D XPoint. Это указывает на то, что случайные записи больше не являются ограничивающим фактором для этих высокопроизводительных PCIe SSD.

Следствия. Сегодня, в эпоху управления данными в основной памяти разрабатываются несколько ядер СУБД на основе предположения, что все данные постоянно находятся в DRAM. Однако резкое сокращение интервала безубыточности, вычисляемого по правилу пяти минут, заставляет усомниться в безупречности этой тенденции к управлению данными в основной памяти на основе DRAM по трем причинам. Во-первых, недавние прогнозы показывают, что, по-видимому, в течение следующих пяти лет плотность записи на SSD будет увеличиваться на 40% ежегодно, опережая темпы увеличения плотности записи у HDD [4]. Напротив, емкость DRAM удваивается каждые три года [15]. В результате флэш-память NAND, вероятно, будет дешеветь быстрее, чем DRAM. Это, в свою очередь, приведет к дальнейшему уменьшению значения экономического сомножителя, что вызовет сокращение интервала безубыточности.

Во-вторых, современные PCIe SSD – это высоко параллельные устройства, которые могут обеспечивать очень высокую пропускную способность произвольного ввода-вывода за счет одновременного обслуживания нескольких заданных операций ввода-вывода. С появлением таких интерфейсов, как NVMe, сквозная задержка доступа к данным PCIe SSD на основе флэш-памяти NAND составляет всего десятки микросекунд. Новые технологии энергонезависимой памяти, такие как 3D XPoint, обещают дальнейшее повышение пропускной способности и сокращение задержек доступа по сравнению с флэш-памятью NAND. Напротив, у DRAM сокращение задержки существенно отстает от повышения пропускной способности, и фактически за последние несколько лет задержка DRAM даже возросла. Также хорошо известно, что для увеличения объема основной памяти системы требуется использование DRAM высокой плотности, а уменьшение задержки доступа при одновременном увеличении плотности битовых эдементов DRAM является сложной проблемой [19]. Таким образом, увеличение числа обращений в секунду к энергонезависимому твердотельному носителю данных, независимо от того, основано ли оно на флэш-памяти NAND или 3D XPoint, приведет к уменьшению технологического сомножителя и, тем самым, к еще большему сокращению интервала безубыточности.

В-третьих, SSD потребляют значительно меньше энергии, чем DRAM. SSD Intel 750 емкостью 1 Тб потребляет 4 Вт энергии в режиме ожидания и 22 Вт в активном состоянии. Напротив, 1 Тб DRAM на сервере потребляет 50 Вт в режиме ожидания и 100 Вт в активном состоянии [1]. Также хорошо известно, что энергопотребление DRAM нелинейно возрастает с увеличением емкости, поскольку DRAM с высокой плотностью потребляет значительно больше энергии, чем аналоги с низкой плотностью. Недавнее исследование, посвященное энергопотреблению в системах баз данных с хранением данных в основной памяти, показало, что на сервере с 6 ТБ памяти мощность, потребляемая DRAM в режиме, соответствует мощности четырех активных процессоров [1].

Такое различие в расходе энергии между SSD и DRAM прямо преобразуется в более высокие производственные расходы (Operational Expenses, OPEX), и, следовательно, более высокую общую стоимость владения (Total Cost of Ownership, TCO) для ядер систем баз данных на основе DRAM по сравнению с их аналогами на основе SSD. Это также отражается в ценах инстансов различных предлагаемых поставщиками облачных услуг виртуальных машин, оптимизированных на использование основной и флэш-памяти. Например, в регионе Amazon East (Северная Вирджиния) стоимость оптимизированного на использование основной памяти экземпляра X1 с 976 Гб DRAM составляет $ 6,66 в час, в то время как экземпляр I3 с NVMe SSD емкостью в 1 Тб стоит $ 0,31 в час. Таким образом, мы видим, что рентабельность SSD по сравнению с DRAM в восемь раз выше, когда в качестве метрики используется стоимость приобретения аппаратных средств (табл. 1, 3), и в 20 раз выше, когда в качестве метрики используется стоимость аренды инстанса. Вычисление интервала безубыточности на основе стоимости аренды инстанса приведет к дальнейшему сокращению интервала в 2,5 раза из-за пропорционального снижения значения экономического сомножителя.

С учетом этих трех факторов и получаемых по правилу пяти минут значений интервала безубыточности нам кажется неизбежным переход от подсистем хранения данными на основе DRAM к подсистемам хранения в постоянной памяти на основе твердотельных накопителей. Фактически, это изменение уже идет полным ходом, поскольку ядра систем баз данных уже обновляются, чтобы в полной мере использовать преимущества производительности PCIe NVMe SSD. Например, Oracle Exadata X6 недавно продемонстрировала пропускную способность выполнения в режиме OLTP 5,6 млн операций ввода-вывода в секунду при чтении и 5,2 млн операций ввода-вывода в секунду при записи с использованием только NVMe SSD [32].

5. Правило пяти минут и уровень емкости

В отличие от уровня производительности, где целью оптимизации для устройств хранения является большое число случайных IOPS, устройства на уровне емкости нацелены на снижение затрат на хранение Гб данных, поскольку этот уровень обычно используется для хранения данных приложений пакетной аналитики, нечувствительных к задержкам доступа. В этом разделе мы представим последние тенденции в оборудовании для хранения данных с высокой плотностью и еще раз рассмотрим правило пяти минут.

5.1 Тенденции в области хранения данных с высокой плотностью

Традиционно HDD с 7200 об./мин. были основными носителями, используемыми для обеспечения уровня емкости. В течение нескольких лет повышение плотности записи позволяло увеличивать емкость HDD со скоростью Крайдера (40% в год), опережая 18-месячное удвоение количества транзисторов, предсказанное законом Мура. Однако за последние несколько лет производители HDD столкнулись с трудностями при масштабировании плотности записи с помощью традиционных методов перпендикулярной магнитной записи (Perpendicular Magnetic Recording, PMR). В результате показатели повышения плотности записи на HDD за последние несколько лет разошлись с показателями Крайдера, и мы наблюдаем ежегодное повышение плотности записи только примерно на 16% вместо 40% [18].

С использованием HDD в качестве предпочтительного носителя на уровне емкости связана и другая проблема: высокий уровень энергопотребления в режиме ожидания. Хотя предприятия накапливают огромные объемы данных, доступ ко всем данным, как и следовало бы ожидать, производится нечасто. По оценкам недавно выполненных исследований, до 80% корпоративных данных являются «холодными», т.е. к ним редко обращаются, и объемы именно холодных данных демонстрируют крупнейшие совокупные годовые темпы роста (Cumulative Annual Growth Rate, CAGR) в 60% [10, 12, 28]. В отличие от ленточных накопителей, которые не потребляют электроэнергию после размонтирования, жесткие диски потребляют значительное количество энергии даже во время простоя. Такое энергопотребление приводит к пропорциональному увеличению производственных расходов. Эти проблемы традиционных HDD с перпендикулярной магнитной записью привели к гонке за разработку устройств с высокой плотностью записи, которые могут существенно снизить стоимость хранения данных в расчете на 1 Гб.

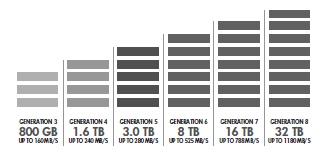

5.1.1 Хранение данных с высокой плотностью на основе лент

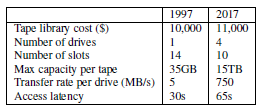

В отличие от жестких дисков, плотность записи на магнитные ленты неуклонно увеличивается со скоростью 33% в год, и, согласно дорожной карте LTO, это будет продолжаться в обозримом будущем, как показано на рис. 2. В табл. 4 показаны показатели цена/производительность ленточных хранилищ в 1997 г. и сегодня. Значения 1997 г. основаны на соответствующей статье о правиле пяти минут [8]. Значения 2017 г. опираются на данные о ленточной библиотеке SpectraLogic T50e [26], в которой используются ленточные картриджи LTO-7. Заметим, что мы показываем значения емкости и пропускной способности для картриджей LTO-7 в режиме сжатия данных. Значения для режима без сжатия в два раза меньше.

Рис. 2. Дорожная карта лент, опубликованная консорциумом LTO [31]

Табл. 4. Характеристики цена/производительность лент

В современных ленточных библиотеках используется несколько ленточных накопителей, и стоимость библиотеки зависит как от количества накопителей, так и от количества допустимых слотов. Сегодня высокопроизводительные ленточные библиотеки могут управлять по максимуму 50 000 ленточных картриджей с использованием 144 лентопротяжных устройств. С 1997 г. емкость отдельных лент увеличилась в 200 раз, общая емкость ленточных библиотек увеличилась с сотен гигабайт до сотен петабайт. Возможно, более интересным, чем снижение стоимости в расчете на Гб данных, является повышение пропускной способности. Сегодня при последовательном доступе к данным пропускная способность одного картриджа LTO-7 может превышать пропускную способность HDD, как показано в табл. 5. Поскольку в ленточных библиотеках используется несколько лентопротяжных устройств, совокупная пропускная способность, достижимая даже при использовании ленточных библиотек начального уровня,. составляет 1-2 Гб/сек. Высококачественные библиотеки могут обеспечивать пропускную способность более 40 Гб/сек. Однако задержка произвольного доступа у ленточных библиотек по-прежнему в 1000 раз выше, чем у HDD (минуты против миллисекунд), поскольку ленточные библиотеки должны загружать и перематывать ленточные картриджи, прежде чем можно будет получить доступ к данным.

5.1.2 Хранение данных с высокой плотностью на основе HDD

Производители HDD также начали работать над несколькими методами повышения плотности записи. Во-первых, использование гелия вместо воздуха позволило поставщикам жестких дисков плотно упаковать большие число пластин и увеличить плотность записи. Во-вторых, в то время как активно исследуются новые методы магнитной записи, такие как термомагнитная запись (Heat-Assisted Magnetic Recording, HMR)13, поставщики HDD , в качестве временной меры для дальнейшего повышение плотности прибегают к использованию черепичной магнитной записи (Shingled-Magnetic Recording, SMR)14, когда соседние дорожки перекрываются. В-третьих, аналогично тому, как в ленточных библиотеках используются несколько лентопротяжных устройств для увеличения пропускной способности, исследователи систем хранения и поставщики оборудования недавно начали разработку стеллажных устройств хранения данных, также называемых устройствами холодного хранения (Cold storage device, CSD), в которых оптимизируются затраты на хранение 1 Гб данных за счет использования набора SMR HDD высокой плотности в виде единой среды хранения.

Каждый CSD представляет собой крупный массив простаивающих дисков (Massive Array of Idle Disks, MAID), в котором в любой момент времени только небольшая часть HDD вращается и активна [3]. Например, в Pelican CSD 1152 диска SMR упаковываются в стойку 52U общей емкостью 5 Пб [24]. Однако в любой момент времени раскручиваются только 8% дисков из-за ограничений, налагаемых системой охлаждения стойки (ее возможностей достаточно для охлаждения только двух дисков в вертикально расположенном наборе дисков), и бюджетом мощности (мощности достаточно для поддержки вращения только двух дисков в каждом лотке). Аналогично, каждый сервер CSD OpenVault Knox [33] хранит 30 жестких дисков SMR в корпусе 2U, из которых только один диск может вращаться, чтобы минимизировать чувствительность дисков к вибрации. Конечным результатом этих ограничений является то, что CSD вводит строгие ограничения на то, сколько и какие диски могут быть активными одновременно. Набор дисков, которые могут быть активными одновременно, называется группой дисков.

Все диски в группе можно раскручивать или останавливать параллельно. Доступ к данным на любом из дисков в раскрученной группе хранения может производиться с задержкой и пропускной способностью, сопоставимыми с характеристиками традиционных средств уровня емкости. Например, CSD Pelican, OpenVault Knox и ArticBlue способны насытить канал Ethernet 10 Гбит, поскольку они обеспечивают пропускную способность 1-2 Гб/сек. для чтения данных с раскрученных дисков [24, 25, 33]. Однако для доступа к данным на диске, который находится в неактивной группе, требуется остановить активные диски и раскрутить новый набор дисков. Эта операция называется групповым переключением. Например, CSD Pelican для выполнения группового переключения требуется восемь секунд. Таким образом, задержка доступа CSD в лучшем случае идентична уровню емкости, а задержка в худшем случае на два порядка выше.

5.2 Интервал безубыточности и следствия

Теперь мы вернемся к правилу пяти минут для случаев DRAM-лента и для HDD-лента. Мы не вычисляем интервал безубыточности для CSD, поскольку информация о стоимости оборудования не является общедоступной. Однако на основе заявлений поставщиков CSD о совокупной стоимости владения мы обсудим, как CSD влияет на правило пяти минут.

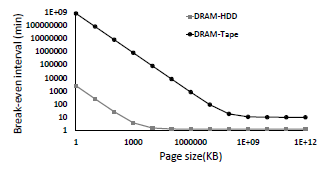

Рис. 3. Асимптоты интервалов безубыточности для случаев DRAM-HDD и DRAM-лента

При использовании показателей из табл. 1 и табл. 4 мы получаем для случая DRAM-лента при размере страницы 4 Кб интервал безубыточности длиннее 300 лет! Джим Грей называл ленточные накопители «мотелями данных», куда данные загружаются и откуда никогда не выгружаются [7], и это, безусловно, верно сегодня. На рис. 3 показано изменение интервала безубыточности для HDD и ленты для разных размеров страниц. Мы видим, что интервал асимптотически приближается к одной минуте в случае DRAM-HDD и десяти минутам в случае DRAM-лента. Асимптота HDD достигается при размере страницы 100 Мб, а асимптота ленты – при размере 100 Гб. Это ясно показывает, что: i) произвольный доступ к данным на этих устройствах является чрезвычайно дорогостоящим, и ii) объемы передачи данных с этих устройств должны быть большими, чтобы амортизировать стоимость произвольного доступа.

Однако сегодня уровень емкости в основном используется не для поддержки приложений, требующих высокопроизводительного произвольного доступа. Скорее, этот уровень предназначается для снижения затрат в расчете на 1 Гб хранения данных, на которых может выполняться аналитика, не чувствительная к задержкам. По этой причине Грей и Грефе отмечали, что число считываемых или записываемых килобайт в секунду (KB-accesses-per-second, Kaps) мало полезно для HDD и лент, поскольку они превращаются в ресурсы бесконечной емкости [8]. Для этих устройств хранения с высокой плотностью больше уместно число считываемых или записываемых мегабайт в секунду (MB-accesses-per-second, Maps) и время, требуемое для последовательного сканирования всего устройства.

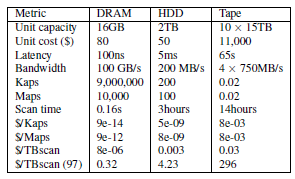

Табл. 5. Показатели цены/производительности DRAM, HDD и ленты

В табл. 5 приведены эти новые показатели и их значения для DRAM, HDD и ленты. В дополнение к Kaps, Maps и времени сканирования, в таблице также показаны $/Kaps, $/Maps и $/TBscan, считая, что затраты амортизируются в течение трехлетнего периода, как было предложено Греем и Грефе [8]. Показатель сканирования можно рассматривать как меру арендной платы за терабайт носителя во время сканирования содержимого носителя. Глядя на цену $/Kaps, мы видим, что DRAM на пять порядков дешевле HDD, которые, в свою очередь, на шесть порядков дешевле лент. Это вполне ожидаемо с учетом огромной разницы в задержках произвольного доступа и согласуется с правилом пяти минут, согласно которому для произвольного доступа к данным рекомендуется использовать DRAM. Глядя на $/Maps, мы видим, что разница между DRAM и HDD сокращается примерно до 1000 раз. Это связано с тем, что жесткие диски могут обеспечить гораздо более высокую пропускную способность при последовательном доступе к данным по сравнению со случайным доступом. Однако жесткие диски по-прежнему на шесть порядков дешевле лент даже при случайном доступе к данным размером в Мб. Это также соответствует асимптоте HDD/ленты, показанной на рис. 3. Наконец, $/TBscan рисует совершенно иную картину. В то время как DRAM остается в 300 раз дешевле жесткого диска, разница между жестким диском и лентой сокращается до 10 раз.

Сравнивая значения $/TBscan со значениями 1997 года, мы можем увидеть две интересные тенденции. Во-первых, с течением времени увеличивается расхождение между DRAM и HDD. В 1997 году для терабайтного сканирования было в 13 раз дешевле арендовать DRAM, чем HDD. Сегодня это в 300 раз дешевле. Это означает, что даже для приложений с интенсивным сканированием неудивительно, что для оптимизации производительности требуется избегать использования жесткого диска в качестве носителя данных. Во-вторых, разница между жестким диском и лентой имеет противоположную тенденцию и со временем сокращается. В 1997 году аренда жесткого диска была в 70 раз дешевле, чем ленточная. Однако сегодня она всего в 10 раз дешевле. В отличие от жестких дисков, в обозримом будущем прогнозируется удвоение пропускной способности ленты для последовательной передачи данных. Следовательно, эта разница, вероятно, будет сокращаться. Таким образом, в ближайшем будущем для стоимости сканирования может не иметь большого значения, хранятся ли данные на ленте или жестком диске.

Следствия. Сегодня все корпоративные данные должны храниться дважды: один раз на традиционном уровне емкости на основе HDD для обеспечения возможности пакетной аналитики, а второй раз на уровне архивирования на магнитной ленте для соответствия нормативным требованиям. Сокращающаяся разница в $/TBscan между HDD и лентой наталкивает на ту мысль, что, возможно, стоит пересмотреть традиционную многоуровневую иерархию, в которой лента используется только на уровне архивирования, а не в оперативном режиме для поддержки пакетной аналитики; Было бы экономически выгодно заменить уровни емкости на основе HDD и архивирования на основе магнитной ленте новым уровнем холодного хранения, который возьмет на себя роль обоих уровней.

Последние тенденции в областях приложений и оборудования показывают, что такое слияние возможно. Приложения пакетной аналитики требуют интенсивного сканирования и нечувствительны к задержкам в отличие от приложений интерактивной аналитики, чувствительных к задержкам. Поскольку интерактивные приложения уже изолированы от уровня производительности, уровень холодного хранения должен только удовлетворять требованиям к пропускной способности приложений пакетной аналитики. Что касается аппаратного обеспечения, то плотность записи у флэш-памяти NAND сегодня выше, чем у HDD и лент. По мере увеличения размера флэш-памяти NAND растет и объем хранения данных на уровне производительности. Поэтому в ближайшем будущем может оказаться экономически целесообразным хранить все данные с произвольным доступом, а также часто используемые данные, к которым требуется быстрый доступ, во флэш-памяти NAND на уровне производительности. Таким образом, уровень емкости будет использоваться для хранения данных, к которым производится последовательный доступ.

Как говорилось ранее, устройства полуоперативного хранения, такие как ленточные библиотеки и CSD, способны обеспечить высокопроизводительный последовательный доступ к данным. Кроме того, наш расчет затрат был основан на стоимости приобретения, а не на совокупной стоимости владения. Учитывая постоянно увеличивающуюся плотность, низкое энергопотребление и более длительный срок службы лент, аналитики недавно сообщали, что решения для архивирования на основе лент имеют почти в шесть раз меньшую совокупную стоимость владения на терабайт хранимых данных по сравнению с архивами на HDD [21]. Утверждается, что устройства холодного хранения обеспечивают совокупную стоимость владения и пропускную способность при последовательной передачи данных, сравнимые с характеристиками ленточных устройств, но при этом задержка произвольного доступа уменьшается с минут до секунд [16, 20]. Таким образом, замена уровней емкости и архивирования одним уровнем холодного хранения может привести к существенной экономии средств предприятий. Недавние исследования показали, что это действительно так [2].

Для практической реализации такого уровня холодного хранения приложения пакетной аналитики должны быть модифицированы для работы напрямую на лентами или CSD. В предыдущих исследованиях третичных баз данных, выполненных в сообществе баз данных, уже изучались методы организации такой системы хранения [22, 23]. Совсем недавно исследователи также начали изучать расширения фреймворков пакетной обработки для обеспечения аналитики непосредственно над данными, хранящимися в ленточных архивах и CSD. Например, в фреймворке Nakshatra реализуются расширения предварительной выборки и планирования ввода-вывода для Hadoop, чтобы можно было запланировать выполнение заданий map–reduce непосредственно над ленточными архивами [13]. Skipper – это среда обработки запросов, в которой используются методы адаптивной обработки запросов в сочетании с настраиваемым кэшированием и планированием ввода-вывода, чтобы обеспечить выполнение запросов над CSD [2]. Опыт Skipper показывает, что для длительных пакетных запросов использование CSD приводит к увеличению времени выполнения запроса всего на 35% по сравнению с традиционными HDD, несмотря на наличие большой задержки раскрутки дисков. При наличии таких фреймворков можно перейти с традиционной четырехуровневой иерархии хранения данных на двухуровневую иерархию с уровнем производительности на основе флэш-памяти NAND или PM и уровнем холодного хранения на основе CSD или магнитных лент.

5. Виды на будущее и заключение

Дизайн систем управления данными всегда определялся изменениями требований приложений и оборудования. В этой статье мы показали новые тенденции в отношении обоих этих аспектов и заново обсудили правило пяти минут.

Что касается приложений, то сегодня существует четкое различие между чувствительной к задержкам интерактивной аналитикой и пакетной аналитикой, которая к задержкам не чувствительна. Поскольку доступ к данным, принадлежащим этим двум классам приложений, различается, они хранятся на разных уровнях: уровнях производительности и емкости.

По мере того, как флэш-память NAND на уровне производительности приближается к центральным процессорам при переходе от использования шины PCIe к использованию шины DRAM, время задержки уменьшается, а пропускная способность значительно увеличивается. Для современных PCIe SSD интервал безубыточности, предсказываемый правилом пяти минут, составляет менее минуты. В будущем дальнейшие совершенствования флеш-памяти NAND и внедрение новых технологий PM, вероятно, приведут к еще большему сокращению интервала безубыточности. По мере того, как окно «повторного использования» данных сужается, в скором времени станет экономически более выгодно хранить большую часть данных (а может быть, и все данные) на устройствах SSD или PM.

Традиционно для реализации уровня емкости использовались жесткие диски c 7200 об./мин. Однако наш анализ показал, что из-за повышения пропускной способности ленты и внедрения CSD в качестве промежуточного звена между HDD и лентой может потребоваться пересмотр разделения уровней емкостью и архивирования. С учетом нечувствительности к задержкам пакетной аналитики и недавних результатов модификации фреймворков анализа данных для работы на лентах/CSD может быть экономически выгодным слияние традиционных уровней емкости и архивирования в один уровень холодного хранения на основе лент/CSD.

Оба этих вывода означают, что введение новых устройств хранения на уровне производительности и емкости может привести к неожиданному эффекту сокращения, а не расширения иерархии хранения. Однако для того, чтобы это произошло, необходимо ответить на несколько открытых вопросов как в отношении аппаратного обеспечения, так и программного обеспечения. Например, на аппаратном уровне для практической реализации уровня холодного хранения требуется поддержка рабочих нагрузок пакетной аналитики на лентах или CSD. Поскольку эти устройства традиционно использовались для архивного хранения данных, где данные редко считываются, возникает интересный вопрос, не пострадает ли надежность этих устройств хранения, если они будут поддерживать пакетную аналитику, при которой данные считываются гораздо чаще, хотя и в последовательном режиме.

Что касается программного обеспечения, то конструкции подсистем хранения данных на основе DRAM и тех, которые основываются на HDD, резко различаются. Важно суметь найти компромиссные конструкции подсистем хранения данных при использовании как устройств PM, так и высокопроизводительных NVMe SSD. Например, в дисковых подсистемах хранения HDD используется в качестве основного уровня хранения и DRAM – в качестве буферного кэша в предположении, что емкость DRAM ограничена. В подсистемах хранения в основной памяти, напротив, устраняются накладные расходы, связанные с кэшированием, поскольку DRAM рассматривается как основной уровень хранения, а HDD/SSD – как анти-кеш в предположении, что большая часть данных умещается в DRAM [5]. Твердотельные накопители NVMe и PM являются достаточно быстрыми, чтобы накладные расходы на кэширование были заметными. Тем не менее, антикэширование не являться оптимальным способом управления ими с учетом того, что большая часть данных больше не находится в DRAM.

Благодарности

Мы хотели бы поблагодарить анонимных рецензентов и членов лаборатории DIAS за их конструктивные отзывы, которые существенно улучшили представление статьи. Эта работа финансируется Школой компьютерных и коммуникационных наук в EPFL и совместным производственно-академическим проектом лаборатории DIAS и Центрального института программного обеспечения Huawei (CSI).

7. Литература

- R. Appuswamy, M. Olma, and A. Ailamaki. Scaling the memory power wall with dram-aware data management. In DAMON, 2015.

- R. Borovica-Gajic, R. Appuswamy, and A. Ailamaki. Cheap data analytics using cold storage devices. PVLDB, 9(12):1029–1040, 2016.

- D. Colarelli and D. Grunwald. Massive arrays of idle disks for storage archives. In Conference on Supercomputing, 2002.

- T. Coughlin. Flash memory areal densities exceed those of hard drives.

- J. DeBrabant, A. Pavlo, S. Tu, M. Stonebraker, and S. Zdonik. Anti-caching: A new approach to database management system architecture. PVLDB, 6(14):1942–1953, 2013.

- G. Graefe. The five-minute rule 20 years later (and how flash memory changes the rules). Commun. ACM, 52(7):48–59, 2009.

- J. Gray. The five-minute rule.

- J. Gray and G. Graefe. The five-minute rule ten years later, and other computer storage rules of thumb. SIGMOD Rec., 26(4), 1997.

- J. Gray and F. Putzolu. The 5 minute rule for trading memory for disc accesses and the 10 byte rule for trading memory for cpu time. In SIGMOD, 1987.

- IDC. Technology assessment: Cold storage is hot again finding the frost point.

- Intel. Optane technology.

- Intel. Cold Storage in the Cloud: Trends, Challenges, and Solutions, 2013.

- A. Kathpal and G. A. N. Yasa. Nakshatra: Towards running batch analytics on an archive. In MASCOTS, 2014.

- B. Laliberte. Automate and optimize a tiered storage environment fast! ESG White Paper, 2009.

- K. Lim, J. Chang, T. Mudge, P. Ranganathan, S. K. Reinhardt, and T. F. Wenisch. Disaggregated memory for expansion and sharing in blade servers. In ISCA, 2009.

- S. Logic. Arctic blue pricing calculator.

- Micron. Memory1.

- F. Moore. Storage outlook 2016.

- O. Mutlu. Rethinking memory system design (along with interconnects). In MEMCON, 2015.

- S. Newsletter. Costs as barrier to realizing value big data can deliver.

- D. Reine and M. Kahn. Continuing the search for the right mix of long-term storage infrastructure a tco analysis of disk and tape solutions, 2015.

- S. Sarawagi. Query Processing in Tertiary Memory Databases. In VLDB, 1995.

- S. Sarawagi and M. Stonebraker. Reordering Query Execution in Tertiary Memory Databases. In VLDB, 1996.

- R. B. Shobana Balakrishnan, A. Donnelly, P. England, A. Glass, D. Harper, S. Legtchenko, A. Ogus, E. Peterson, and A. Rowstron. Pelican: A building block for exascale cold data storage. In OSDI, 2014.

- Spectra. Arcticblue deep storage disk.

- SpectraLogic. Spectralogic t50e.

- StorageReview. Intel optane memory review.

- H. I. Strategies. Tiered storage takes center stage. Report, 2015.

- D. Technologies. Memory1.

- TPC-C. Dell-microsoft sql server tpc-c executive summary, 2014.

- L. Ultrium. Lto ultrium roadmap.

- K. Umamageswaran and G. Goindi. Exadata: Delivering memory performance with shared flash.

- M. Yan. Open compute project: Cold storage hardware v0.5, 2013.