2015 г.

Энергонезависимая основная память становится реальностью

Сергей Кузнецов

Обзор августовского, 2013 г. номера журнала Computer (IEEE Computer Society, V. 46, No 8, Август 2013).

Авторская редакция.

Также обзор опубликован в журнале «Открытые системы»

Темой августовского номера являются новые технологии компьютерной памяти (Next-Generation Memory). Так же называется и вводная заметка приглашенных редакторов, которыми на этот раз являются Грег Этвуд, Су-Ик Чей и Саймон Шим (Greg Atwood, Micron Technology, Soo-Ik Chae, Seoul National University, Simon S.Y. Shim, San Jose State University).

Технологии устройств хранения данных, используемые в современных компьютерных системах, появились в 1970-е гг. на заре становления индустрии полупроводников. Твердотельная память (статическая память (static RAM, SRAM), динамическая память (dynamic RAM, DRAM) и флэш-память (исходно называвшаяся EPROM – Electronically Programmable Read Only Memory) основывалась на использовании транзисторных электронных устройств, а механическая память (магнитные ленты и диски) – магнитных накопителей. Эти две разновидности устройств хранения прожили поразительно долгую жизнь, причем в соответствии с законом Мура каждые два года удваивалась плотность записи и вдвое уменьшалась стоимость. Масштабируемость этих технологий во многом способствовала появлению все более сложных компьютерных устройств.

Устройство памяти является определяющим компонентом многих сегодняшних портативных устройств, которые становятся обязательной составляющей жизни людей. В смартфоне или планшете память стоит почти столько же, что и дисплей, намного больше, чем процессор. В высокопроизводительных вычислительных системах (например, серверах) устройство памяти определяет общую производительность системы в гораздо большей степени, чем любой другой компонент. По мере того, как продолжают возрастать объемы данных, которые должны быть мгновенно доступны миллионам пользователей, технология памяти становится и решением, и препятствием, побуждая компьютерную индустрию пересматривать способы использования памяти в соответствующих системах. Одним из наилучших примеров этой тенденции является широкое внедрение твердотельных накопителей (solid-state drive, SSD) в самые разные компьютерные устройства.

Быстрое наращивание плотности записи и падение стоимости стали возможным благодаря постоянному уменьшению размеров элементов. К сожалению, это масштабирование ограничено законами физики, что делает все более трудной задачу поддержки такого же роста эффективности устройств памяти. В современных 20-нанометровых многоуровневых ячейках (multilevel cell, MLC) NAND состояние памяти сохраняется с использованием всего лишь нескольких десятков электронов. Для использования такой памяти в системах требуются все более сложные устройства управления памятью. К счастью, возможность современных средств производства работать с материалами на атомном уровне совместно с развитием теоретических основ устройств хранения данных открывают пути к новым достижениям в этой области. Новые устройства хранения данных могут оказаться еще более масштабируемыми, чем те, которые существуют сегодня, обеспечивая дальнейший рост эффективности.

Первая статья тематической подборки (а всего их пять) называется «Флэш-память NAND: проблемы и возможности» («NAND Flash Memory: Challenges and Opportunities») и написана Яном Ли и Хандкером Квадером (Yan Li, Khandker N. Quader, SanDisk).

Со времени появления на рынке в 1987 г. флэш-памяти NAND ее относительно низкая стоимость, компактность, бесшумность, скорость и прочность привели к ее широкому использованию в мобильных платформах (в частности, в смартфонах и планшетах) и отказу в ее пользу от жестких дисков во многих клиентских и корпоративных приложениях.

В последние годы разработчики смогли успешно масштабировать двумерную флэш-память NAND (2D NAND) к 20-нанометровой технологии, но дальнейшее масштабирование может стать значительной проблемой. Хотя новые альтернативы, такие как трехмерная резисторная память с произвольным доступом (3D resistive RAM, ReRAM), нацелены на замену двумерной флэш-памяти NAND, крепкие позиции этой технологии на рынке энергонезависимых устройств хранения данных и привлекательность низкого уровня энергопотребления не позволят легко ее вытеснить. Например, в корпоративных системах хранения данных, основанных на использовании SSD, уже применяется массивный параллелизм, позволяющий поддерживать высокий темп поступления операций ввода-вывода с меньшим энергопотреблением и более низкими затратами, чем какая-либо другая практически доступная технология.

При наличии этих серьезных преимуществ флэш-память NAND может частично вытеснить с рынка DRAM, и эксперты ожидают существенного расширения использования этой памяти в мобильных, корпоративных и клиентских продуктах. По предсказанию компании Garner в ближайшие пять лет число используемых накопителей SSD утроится, а емкость SSD возрастет в среднем в 4-5 раз.

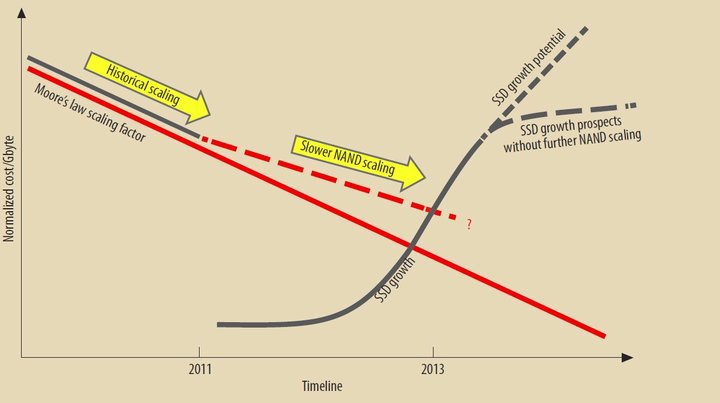

Стоимость гигабайта флэш-памяти NAND с учетом коэффициента масштабирования. В последние годы исторические темпы масштабирования NAND замедлились (пунктирная красная линия), в то время как спрос на флэш-память NAND подпитывается впечатляющим ростом рынка SSD.

Широкое распространение флэш-памяти приведет к дальнейшему уменьшению ее стоимости, которое станет допустимым для производителей по причине возрастающей масштабируемости. Дальнейшая миниатюризация устройств флэш-памяти NAND ставит перед системами управления этой памятью проблему поддержки надежности при сохранении проблемы пониженной износоустойчивости.

Для поддержки надежности флэш-памяти NAND масштаба 19 и менее нанометров потребуются новые алгоритмы организации памяти и систем управления ею. Много проводимых исследований посвящено архитектуре памяти, ее надежности, потребляемой мощности и высокоскоростным интерфейсам ввода-вывода. В ряде других исследований проблемы масштабирования двухмерной флэш-памяти NAND решаются за счет перехода к трехмерным ячейкам и использования других технологий.

Авторами статьи «Какое будущее у технологий резистентной памяти?» («What Lies Ahead for Resistance-Based Memory Technologies?») являются Юн-Жон Сон, Гитае Жеон, Ин-Гиу Бейк и Жундал Чой (Yoon-Jong Song, Gitae Jeong, In-Gyu Baek, Jungdal Choi, Samsung Electronics).

Устройства памяти быстро приближаются к техническому пределу возможности масштабирования, что стимулирует интерес с новым технологиям. В традиционной памяти, такой как DRAM и флэш-память NAND, используется емкость электрического заряда, сохраняемого в ячейке памяти. При сокращении объема устройства хранения устройствам приходится учитывать возможность неконтролируемого падения емкости в ячейке уменьшенного размера.

Некоторые исследователи пытаются решить эту проблему путем использования в современных устройствах новых архитектур, например, флэш-памяти NAND с вертикальной компоновкой (vertical NAND). Другие разрабатывают новые устройства резистентной памяти, такой как память на основе фазовых переходов (phase-change RAM, PRAM), магнитная память с произвольным доступом (magnetic RAM, MRAM) и резистентная память (resistive RAM, ReRAM). Эти разновидности энергонезависимой памяти быстрее емкостной памяти и легче масштабируются к размерам, меньшим 20 нанометров. У каждой из новых разновидностей памяти имеется свой сегмент рынка. MRAM демонстрирует наилучшие скоростные характеристики, что делает эту память энергонезависимой альтернативой DRAM. PRAM и ReRAM быстрее флэш-памяти и, соответственно, могут соперничать с ней на флэш-рынке.

Для лучшего понимания возможных вариантов использования памяти производители полупроводниковых устройств должны понимать ключевые характеристики и существующие технологические процессы этих трех новых видов памяти. Соответствующий краткий обзор приводится в данной статье.

Статью «Преобразование клиентской системы хранения при использовании энергонезависимой памяти» («The Nonvolatile Memory Transformation of Client Storage») написали Эмбер Хаффман и Дейл Джунманн (Amber Huffman, Dale Juenemann, Intel).

Внедрение твердотельных накопителей в серийно выпускаемые компьютерные системы приводит к изменению облика клиентских систем хранения данных. Происходят два основных преобразования: появляются новый интерфейс с устройствами хранения данных, ориентированный на использование энергонезависимой памяти (nonvolatile memory, NVM), и новые решения кэширования, расширяющие достоинства NVM для более широкого круга пользователей за более доступную цену.

На уровне аппаратных интерфейсов интерфейс Serial ATA (SATA) заменяется последовательным интерфейсом периферии PCI Express (Peripheral Component Interconnect Express, PCIe) для обеспечения более высокой производительности. Для раскрытия всего потенциала NVM в индустрии специфицирован программный интерфейс NVM Express (NVMe), оптимизированный для работы с SSD через PCI. Интерфейс NVMe был разработан с нуля с учетом всех особенностей NVM для обеспечения высокопропускного и надежного решения с низким уровнем задержки.

На уровне системы хранения исследователи борются с проблемой высокой удельной стоимостью (в расчете на гигабайт) флэш-памяти NAND по сравнению с традиционными жесткими дисками. Для достижения производительности, аналогичной производительности SSD, за доступную цену требуются механизмы кэширования, масштабируемые до емкости в несколько гигабайт.

Статья «Как энергонезависимая память изменит программные системы» («How Persistent Memory Will Change Software Systems») представлена Анирудом Бадамом (Anirudh Badam, Microsoft Research).

Принято считать, что основная память является адресуемой с точностью до байта, быстрой и энергозависимой, а внешняя память – адресуемой с точностью до блока, медленной и энергонезависимой. Однако новые технологии энергонезависимой памяти скоро заставят во многом отказаться от этих представлений. В частности, обещается, что энергонезависимая память будет сочетать возможность байтовой адресации и скорость DRAM с энергонезависимостью дисковой и флэш-памяти, обеспечивая при этом большую емкость и лучшую энергоэффективность.

В последнее десятилетие твердотельные накопители на основе флэш-памяти NAND привели к революционным изменениям подсистем хранения данных. Сокращая на два порядка задержку ввода-вывода по сравнению с магнитными дисками, SSD изменяют способы использования приложениями внешней памяти. Многие прототипы энергонезависимой памяти сулят привести к аналогичным преобразованиям подсистем основной памяти, обеспечивая энергонезависимость и потенциальную емкость, на порядок большую допустимой емкости DRAM, при сохранении того же уровня задержки (по крайней мере, для операций чтения).

Исследователи в областях файловых систем, СУБД и операционных систем прилагают усилия к тому, чтобы научиться применять эту приближающуюся технологию. Байтовая адресация очень хороша для технологий управления данными – файловых систем и СУБД, Однако для использования свойства энергонезависимости памяти потребуются изменения в управлении виртуальной памятью. Исследователи уже изучают системы основной и внешней памяти, в которых используется энергонезависимая память, но открытой проблемой является необходимость разработки структуры системы на ранней стадии проекта. Эксперименты в Microsoft Research показывают, что системы, основанные на использовании флэш-памяти, обладают многими недостатками, свойственными и прототипам, базирующимся на энергонезависимой памяти, так что полученный ранее опыт можно применить и к новой технологии.

По мере совершенствования технологии энергонезависимой памяти станет реальной и практичной полная или частичная замена ею технологий DRAM, флэш-памяти и жестких дисков. В то же время, усиление возможностей традиционных технологий возможностями энергонезависимой памяти может принести практическую выгоду без потребности в серьезных переделках приложений.

Последнюю статью тематической подборки под названием «Реорганизация, сокращение, повторное использование: реструктуризация стека ввода-вывода для будущих систем хранения данных» («Refactor, Reduce, Recycle: Restructuring the I/O Stack for the Future of Storage») написали Стивен Свэнсон и Адриан Колфилд (Steven Swanson, Adrian M. Caulfield, University of California, San Diego).

Создание в IBM в 1956 г. первого накопителя на жестких магнитных дисках коренным образом изменило способы хранения данных в компьютерных системах, но с тех пор разработчики компьютерных систем были вынуждены бороться с недостаточной производительностью систем хранения данных, которая сильно отстает от производительности основной памяти, процессоров и сетей. Эта реальность оказала сильное влияние на эволюцию компьютерной аппаратуры, системного программного обеспечения и приложений. В частности, низкая производительность аппаратуры хранения данных привела к тому, что производительность программного обеспечения, управляющего системой хранения (локальных и удаленных файловых систем, драйверов аппаратуры хранения данных, сетей хранения данных, СУБД и систем поддержки виртуальной памяти), относительно несущественна для общей производительности системы.

Появление быстрой энергонезависимой памяти, такой как флэш-память и память на основе фазовых переходов (phase-change memory, PCM) полностью изменяет отношение к производительности систем хранения данных. От разработчиков программного обеспечения требуется переосмысление роли программного обеспечения в таких системах. Задержки и потребление энергии в системах хранения по вине программного обеспечения будут становиться доминирующими расходами, и это будет вынуждать переделывать эти системы для минимизации этих расходов.

В существующих дисковых системах программное обеспечение играет важную роль для повышения производительности системы. Например, более тщательное планирование операций доступа к внешней памяти или более интеллектуальное управление буферным пулом баз данных может существенно сократить и число и стоимость операций ввода-вывода. Программное обеспечение также может обеспечивать полезные сервисы: репликацию, шифрование, сжатие, транзакционность, отслеживание происхождения данных и т.д.

Но на выполнение всего этого кода тратятся и время, и энергия. Для дисковых систем хранения расходы программного обеспечения часто являются мизерными по сравнению с расходами аппаратуры. Например, для выполнения доступа к четырехкилобайтному блоку стандартного диска на программный стек ОС Linux приходятся всего 0.3% задержки и 0,4% энергопотребления.

Переход к использованию NVM полностью изменяет это положение дел. При таком же четырехкилобайтном доступе к прототипному SSD, созданному в лаборатории авторами статьи, на программное обеспечение приходятся 70% задержки и 87.7% энергопотребления. Это означает, что использование существующих программных стеков для работы с внешней памятью при переходе к новым технологиям ведет к разочарованию и неэффективности. Результирующая система просто не сможет раскрыть потенциал NVM.

Для обеспечения эффективного использования NVM требуется переосмыслить роль и структуру программного обеспечения и аппаратуры в системах хранения данных. Авторы статьи потратили четыре года на переконструирование программного обеспечения и аппаратуры и выявили три принципа, полезных для эффективного использования NVM при минимизации числа деструктивных изменений в других компонентах системы:

- реорганизация аппаратуры и программного обеспечения системы хранения данных для сокращения проблем, вызываемых программным обеспечением;

- сокращение накладных расходов программного обеспечения;

- повторное использование существующих компонентов.

Эти принципы были выработаны и проверены при разработке нескольких прототипов систем хранения данных, нацеленных на эффективное использование возможностей NVM.

Вне тематической подборки опубликованы две крупных статьи. Авторами статьи «Анализ бинарного кода» («Binary Code Analysis») являются Кайпин Лью, Хи Бен Куан Тан и Ксу Чен (Kaiping Liu, Hee Beng Kuan Tan, Nanyang Technological University, Singapore, Xu Chen, Chinese Academy of Sciences, Beijing)

Ключевой задачей кибербезопасности является выявления уязвимостей программного обеспечения и обнаружение вредоносного программного обеспечения. Если исходный текст программы недоступен, что обычно так для программных систем и всегда так для вредоносных программ, исследователи безопасности вынуждены анализировать бинарный код.

Методы анализа бинарного кода делятся на статические и динамические. Статический анализ заключается в исследовании программы без ее запуска для получения общих характеристик программы, являющихся ее инвариантными свойствами. Динамический анализ состоит в исследовании программы на основе конкретных трасс выполнения. У обоих подходов имеются сильные стороны и недостатки.

Проблемой анализа бинарного кода является неразличимость данных и кода. Кроме того, поскольку бинарный код лишен явных абстракций (например, абстракции функции), структуру программы можно вывести только на основе команд передачи управления. Тем не менее, исследователи разработали несколько успешных методов анализа бинарного кода, обзору которых и посвящена основная часть статьи.

Наконец, последняя крупная статья августовского номера называется «Перевод на новый уровень систем осязаемого взаимодействия» («Moving Tangible Interaction Systems to the Next Level») и написана Элизой ван ден Ховен, Эвелин ван де Гарде-Перик, Сержем Оффермансом, Коеном ван Боердонк и Карсом-Мишелем Ленссеном (Elise van den Hoven, University of Technology, Sydney, and Eindhoven University of Technology, Evelien van de Garde-Perik, Serge Offermans, Koen van Boerdonk, Eindhoven University of Technology, Kars-Michiel H. Lenssen, Philips Research).

Серьезный интерес к осязаемому взаимодействию (tangible interaction, TI) привел к разработке многочисленных систем, теорий и фреймворков. Все они посвящены возможности обеспечения взаимодействия людей и вычислительных систем с использованием физических объектов для представления цифровых данных и управления ими. TI расширяет возможности визуального взаимодействия, охватывая все чувства человека, и обладает громадным потенциалом для преобразования способов взаимодействия пользователей с цифровыми данными.

Для обеспечения лучшего понимания возможностей TI авторы статьи проанализировали имеющуюся литературу, посвященную системам, теориям и фреймворкам TI. Это позволило выявить основы TI и понять, каким образом разработчики могут использовать соответствующие фундаментальные принципы для создания систем TI с требуемым качеством представления данных и управления ими. Авторы установили, что многие работы посвящены поиску коренных отличий TI от неосязаемого взаимодействия для определения границ области TI (например, следует ли считать осязаемым взаимодействием взаимодействие через компьютерную мышь, сенсорный экран или посредством жестов?).

Хотя выявление этих различий может быть важным при разработке таксономии или фреймворка, авторы полагают, что более важны исследования, в которых выявляются потенциальные достоинства TI. Это было бы первым шагом на пути к созданию качественно новых интерактивных систем. Во многих изученных авторами системах использование TI явно добавляет важное качество, но разработчики не решаются двигаться дальше для применения всех возможностей TI. Отсутствие должного прогресса отчасти объясняется отсутствием согласия в сообществе разработчиков пользовательских интерфейсов относительно границ применимости TI.

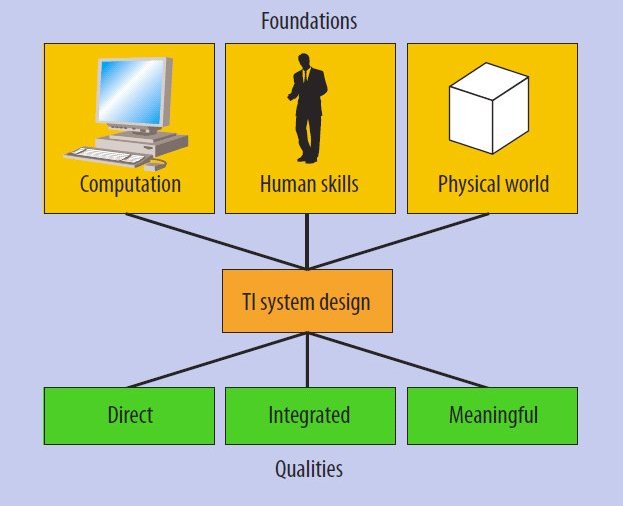

Элементы осязаемого взаимодействия. Комбинирование фундаментальных принципов может привести к появлению систем TI, которые делают намного больше, чем просто осязаемость цифровых данных.

На рисунке показаны элементы, выявленные авторами статьи при обзоре литературы и анализе систем TI. Чтобы систему можно было отнести к категории TI, в ней должны присутствовать все эти элементы (хотя бы частично). Базовыми составляющими являются фундаментальные принципы, которые должны комбинироваться в некоторой форме в любой системе TI. Качество относится к представлению цифровых данных и управлению ими.