2011 г.

От микропроцессоров к нанохранилищам данных

Сергей Кузнецов

Обзор январского, 2011 г. номера журнала Computer (IEEE Computer Society, V. 44, No 1, January 2011).

Авторская редакция.

Также обзор опубликован в журнале "Открытые системы"

По многолетней традиции редакция журнала Computer посвящает январский выпуск перспективным исследовательским работам, которые, вероятно, будут оказывать влияние на развитие информационной технологии в следующие несколько лет. В этом году таким работам посвящаются четыре из шести больших статей январского номера журнала, и с них я начну обзор.

Статья «Производительность компьютеров: игра окончена или новый уровень?» («Computing Performance: Game Over or Next Level?») представлена Сэмьюэлом Фаллером и Линетт Миллетт (Samuel H. Fuller, Analog Devices Inc., Lynette I. Millett, National Research Council).

В конце 2010 г. Совет по компьютерной науке и телекоммуникациям (Computer Science and Telecommunications Board, CSTB) Национальной академии наук США (US National Academy of Sciences) выпустил под редакцией авторов данной статьи книгу «Производительность будущих компьютеров: игра окончена или новый уровень?» («The Future of Computing Performance: Game Over or Next Level?», http://www.nap.edu/catalog.php?record_id=12980). При содействии Национального научного фонда США (US National Science Foundation) CSTB образовал экспертный комитет для выявления основных проблем, стоящих на пути дальнейшего роста производительности компьютеров, и формирования общих черт программы исследований, соответствующих компьютерным потребностям 21-го века. Для этого эксперты представили разные точки зрения относительно областей полупроводниковой технологии, компьютерных архитектур, языков и методов программирования, а также приложений.

Чтобы обеспечить более точное представление об опубликованном документе, приведу перевод его авторской аннотации.

У информационной технологии (ИТ) имеется потенциал для продолжения кардинальных изменений в образе нашей жизни и работы. Можно было бы ожидать, что будущие достижения ИТ появятся вследствие естественного развития ошеломляющих результатов, полученных в последние 50 лет, но реальное положение дел является более отрезвляющим.

Достижения последних 50 лет в области ИТ во многом опирались на быстрый рост производительности отдельных процессоров (за последние 20 лет эта производительность увеличилась в 10000 раз) при постоянно снижаемой стоимости и контролируемом повышении потребляемой энергии. Рост производительности происходил за счет увеличения числа и повышения скорости работы полупроводниковых приборов, используемых в интегральных микросхемах процессоров, на основе миниатюризации транзисторов, и это (вместе с повышением пропускной способности основной и внешней памяти, а также сетевой аппаратуры) позволяло создавать все более мощные компьютерные системы. Для масштабного внедрения ИТ было важно то, что феноменальный рост производительности достигался при сохранении поддержки модели последовательной хранимой программы, модели, разработанной для компьютеров в 1940-е годы. Кроме того, производители компьютеров обеспечивали совместимость конкретной системы команд для нескольких поколений компьютерной аппаратуры, т.е. на новом компьютере можно было выполнять новые приложения, а существующие приложения работали быстрее. Таким образом, не требовалось переписывать программное обеспечение для каждого нового поколения аппаратуры, и имелся простор для целеустремленности и творческой фантазии при создании все более инновационного, эффективного и насыщенного вычислениями программного обеспечения. В свою очередь, это побуждало коммерческие и государственные предприятия, а также рядовых потребителей покупать компьютерные программные и аппаратные средства последующих поколений. Достижения в областях программного и аппаратного обеспечения взаимно подпитывали друг друга, порождая эффективный экономический цикл ИТ.

В начале 21-го века рост производительности отдельных процессоров, измеряемой числом команд, которые могут быть выполнены за одну секунду, замедлился, и теперь такая производительность возрастает с очень умеренной скоростью, если вообще возрастает. Это неожиданное изменение объяснятся фундаментальными ограничениями энергоэффективности интегральных схем, основанных на технологии комплементарных металло-оксидных полупроводников (используемой практически во всех сегодняшних процессорных кристаллах). В результате, очевидным образом, ограничивается эффективность, которой можно добиться в однопроцессорных архитектурах. При этом миниатюризация полупроводниковых устройств продолжается, и в одну интегральную схему можно по-прежнему встраивать все большее число транзисторов, хотя и без прежнего ускорения процессоров. В результате компьютерная индустрия начала производить чипы с несколькими процессорами. В современных чипах поддерживается от нескольких сложных процессоров до сотен более простых процессоров, и в следующих поколениях чипов тенденция к увеличению числа процессоров сохранится. К сожалению, это изменение аппаратуры приводит к необходимости соответствующего изменения в модели программирования. Для использования однокристальных мультипроцессоров в приложениях необходимо использовать модель параллельного программирования, при следовании которой программа разбивается на части, которые затем выполняются параллельно на разных процессорах. Однако основная часть сегодняшнего программного обеспечения написана в соответствии с моделью последовательного программирования, и приложения, написанные подобным образом, невозможно ускорить просто за счет использования параллельных процессоров.

Единственный предсказуемый способ продолжить рост производительности состоит в том, чтобы привести в соответствие параллельную аппаратуру с параллельным программным обеспечением и обеспечить переносимость нового программного обеспечения на параллельную аппаратуру следующих поколений. В некоторых областях программного обеспечения наблюдается значительный прогресс, например, в некоторых научных приложениях, а также в коммерческих поисковых и транзакционных приложениях. Героические программисты способны использовать огромное число параллельных процессоров, процветают проблемно-ориентированные языки, и сложность программирования скрывается мощными абстракциями. Однако ни один из этих подходов не подходит для повсеместной поддержки программирования параллельной аппаратуры, что требуется для обеспечения в следующие двадцать лет такого же оглушительного воздействия ИТ на общество, какое наблюдалось в последние пятьдесят лет.

По этим причинам Комитет по поддержке роста производительности компьютеров (Committee on Sustaining Growth in Computing Performance) рекомендует обратить намного большее внимание на исследования и разработки, посвященные совершенствованию параллельной обработки и переходу к параллельному компьютингу. Наивысшим приоритетом следует наделить следующие направления исследований:

- алгоритмы, допускающие параллельную обработку;

- новые компьютерные «стеки» (приложения, языки программирования, среды поддержки времени выполнения/виртуальные машины, операционные системы и архитектуры), которые позволяют выполнять параллельные, а не последовательные программы, и которые эффективно управляют программным параллелизмом, аппаратным параллелизмом, энергопотреблением, основной памятью и другими ресурсами;

- модели переносимого программирования, позволяющие программистам просто выражать параллельные конструкции и обеспечивающие повторное использование программного обеспечения на развивающихся аппаратных средствах следующих поколений;

- параллельные компьютерные архитектуры, управляемые приложениями, включая развитие однокристальных мультипроцессоров, традиционных архитектур с распараллеливанием по данным, архитектур, ориентированных на приложения, и совершенно новых архитектур;

- открытые стандарты интерфейсов систем параллельного программирования, стимулирующие сотрудничество и инновации для ускорения перехода к практическим параллельным компьютерным системам;

- инженерные и научные учебные программы, в которых уделяется повышенное внимание параллелизму и использованию различных методов и подходов для лучшей подготовки студентов к использованию компьютерных ресурсов, с которыми им придется встретиться в течение своей карьеры.

Хотя все эти области важны, фундаментальные ограничения энергоэффективности не позволят при всем старании получить полное решение. Долговременный рост производительности параллельных компьютерных систем удастся обеспечить только если они станут более энергоэффективными. Поэтому, кроме активизации исследований в областях параллельной обработки, необходимы исследования и разработки, направленные на повышение энергоэффективности компьютерных систем на всех уровнях технологии, включая устройства, аппаратную архитектуру и программные системы.

Статью «От микропроцессоров к нанохранилищам: переосмысление систем, ориентированных на данные» («From Microprocessors to Nanostores: Rethinking Data-Centric Systems») написал Партасарати Ранганатан (Parthasarathy Ranganathan, HP Labs).

Как будут выглядеть будущие компьютерные системы? Мы вступаем в увлекательную эпоху проектирования систем. Исторически первый компьютер, достигший терафлопной производительности (1012, или триллион операций в секунду), был продемонстрирован в конце 1990-х. В 2000-х появился первый петафлопный компьютер с производительностью, большей в тысячу раз (1015). Экстраполируя эти данные, мы можем ожидать, что первый эксафлопный (1018) компьютер появится в конце этого десятилетия.

Кроме непрерывного повышения производительности, мы также наблюдаем огромный прогресс в областях энергопотребления, жизнеспособности, управляемости, надежности и масштабируемости. В частности, управление электропитанием теперь является одним из основных конструктивных элементов. В настоящее время системные архитекторы не ограничиваются оптимизацией операционного энергопотребления, а анализируют весь жизненный цикл энергопотребления системы для обеспечения экологической устойчивости. Подобно этому, появление «облачных вычислений» (cloud computing) не только способствовало развитию новой модели предоставления компьютерных ресурсов, но также позволило добиться значительного прогресса в отношении масштабируемости, а также привело к ряду инноваций в программном обеспечении.

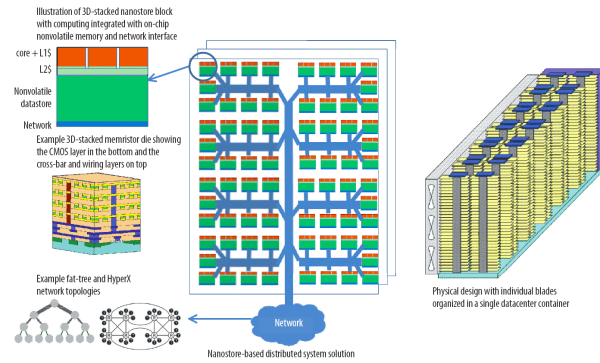

Если смотреть еще дальше, то оказывается, что появляющиеся технологии фотоники, энергонезависимой памяти, трехмерной компоновки интегральных схем (3D stacking), а также новые рабочие нагрузки, ориентированные на обработку данных, обеспечивают новые притягательные возможности. Сочетание этих тенденций побуждает переосмыслить основные строительные блоки будущих систем и предложить новый архитектурный подход нанохранилищ, ориентированный на поддержку рабочих нагрузок обработки данных и на совместную разработку аппаратуры и программного обеспечения на основе грядущих технологий.

Термин «нанохранилище» вводится автором как альтернативный термину «микропроцессор», подчеркивая важность развития нанотехнологии и вынося на первый план данные, а не вычисления. Ключевой характеристикой нанохранилищ является совместное размещение процессоров и энергонезависимой памяти, что устраняет многие промежуточные уровни иерархии хранения данных. Все данные хранятся в одноуровневой энергонезависимой памяти, заменяющей уровни традиционной дисковой памяти и динамической основной памяти. Диски используются только для хранения архивных копий.

Автор надеется, что публикация его статьи приведет к обсуждению, которое будет способствовать созданию новых архитектур будущих систем, ориентированных на обработку данных.

Следующая статья называется «Устранение разрыва плотности соединений для эксамасштабных вычислений» («Bridging the Interconnection Density Gap for Exascale Computation») и написана Дэниэлом Стивенсоном и Робертом Конном (Daniel S. Stevenson, Robert O. Conn., RTI International’s Center for Materials and Electronic Technologies).

При разработке следующих поколений высокопроизводительной компьютерной аппаратуры системным архитекторам придется столкнуться с тяжелыми проблемами. Потребляемая мощность должна уменьшаться, пропускная способность каналов «процессор-память» и «процессор-процессор» – увеличиваться, а расстояние между компонентами – значительно сокращаться. Хотя на горизонте видно несколько архитектурных подходов, наиболее перспективными кажутся технологии крупномасштабных трехмерных полупроводниковых интерфейсов (3D silicon interposer, 3DSI), традиционных бескорпусных кристаллов и новейших трехмерных схем, компонуемых из бескорпусных кристаллов. По мнению авторов, компоновка бескорпусных кристаллов на различных кремниевых подложках, по-видимому, является наиболее эффективным подходом к решению проблем проектирования эксамасштабных выислительных систем и других высокопроизводительных приложений, которые, вероятно, появятся в следующем десятилетии.

В последние 5 лет авторы исследовали применение технологии 3DSI в высокопроизводительных вычислительных системах для поддержки, в частности, отказоустойчивости в эксамасштабных системах. Вначале основное внимание уделялось проектированию реконфигурируемых компьютерных систем, но позже акцент был перенесен на традиционные высокопроизводительные вычислительные системы. Эти исследования позволили получить серьезные результаты в областях разводки питания и сигналов, управления температурным режимом, вертикальной интеграции модулей и взаимосвязи модулей. На основе этих результатов появилась идея многослойных 3DSI, в которых каждый слой оптимизируется для поддержки некоторой уникальной функции.

Идея присоединения бескорпусных чипов прямо к полупроводниковым пластинам и другим подложкам для миниатюризации монтажной схемы не нова. Однако до сих пор площадь компоновочных узлов, в основном, не могла превышать 1 квадратный дюйм из-за наличия двух серьезных производственных проблем: отслоения металлических связей от поверхности полупроводников в ходе ускоренного старения и уменьшения процента выхода годной продукции, включающей частично протестированные кристаллы.

Новые достижения позволяют снять эти ограничения на размеры. Совершенствование процесса производства и переход индустрии с алюминия на медь приводят к существенно лучшему сцеплению металлических связей. Разработка отказоустойчивых металлических структур позволяет теперь производить надежные монтажные схемы большой площади (до 100×125 мм2). Наконец, в последние годы большой прогресс достигнут в области тестирования бескорпусных кристаллов, возможно, из-за их потребности в приложениях трехмерной графики. Теперь можно получать полностью протестированные бескорпусные кристаллы основной памяти и использовать неразрушающие методы тестирования бескорпусных кристаллов.

Последняя статья «тематической» части журнала называется «Апоптический компьютинг: программируемая смерть по умолчанию систем, основанных на компьютерах» («Apoptotic Computing: Programmed Death by Default for Computer-Based Systems») и написана Роем Стерритом (Roy Sterritt, University of Ulster).

На международной конференции по искусственному интеллекту в 2009 г. исследователи предупреждали, что кошмарные сценарии научно-фантастических кинофильмов (таких как «2001: космическая Одиссея», серии «Терминатор» и «Матрица», «Особое мнение» и «Я, робот») могут оказаться вполне правдивыми. Британская «Санди Таймс» заявила, что «ученые боятся восстания роботов-убийц» (http://technology.timesonline.co.uk/tol/news/tech_and_web/article6736130.ece), указав на предостерегающие выступления на этой конференции, в которых говорилось, что человечество может утратить контроль над компьютерными системами, выполняющими все возрастающую долю рабочей нагрузки людей (от звонков по телефону до объявления войны) и уже достигшими уровня устойчивости к разрушению, сопоставимой с живучестью таракана. Например, беспилотные самолеты, способные отыскивать и уничтожать человеческие цели, уже вышли за пределы кинотеатров и используются на полях военных действий Афганистана и Ирака. Хотя в настоящее время такие беспилотные самолеты контролируются операторами, дело идет к обеспечению их автономным управлением. Аналогичные устройства могут вскоре появиться над городскими улицами для обеспечения внутреннего контроля. Южнокорейская компания Самсунг разрабатывает роботов-часовых для несения пограничной службы с возможностью «стрельбы на поражение».

Чтобы предотвратить возможность подобного будущего, с 2002 г. в университете Ольстера выполняется проект Apoptotic Computing, долговременной целью которого является обеспечения программируемой смерти по умолчанию систем, основанных на компьютерах. (Как указывает Википедия, в биологии апоптоз – это форма гибели клетки, проявляющаяся в уменьшении её размера, конденсации и фрагментации хроматина, уплотнении наружной и цитоплазматической мембран без выхода содержимого клетки в окружающую среду. Несмотря на то, что обычно более принципиальным является аспект программированности и активный характер гибели, чем сопутствующие ей морфологические изменения, чаще используется термин «апоптоз», вероятно, из-за его краткости (http://ru.wikipedia.org/wiki/%D0%90%D0%BF%D0%BE%D0%BF%D1%82%D0%BE%D0%B7)). Апоптический компьютинг мотивируется механизмом апоптоза в многоклеточных организмах, и этот подход можно считать относящимся к областям биоинспирированного компьютинга (bio-inspired computing), природного компьютинга (natural computing) и самоуправляемых систем (autonomic system). В статье рассматриваются два примерных класса приложений: автономные среды, основанные на использовании агентов, и разведывательные системы с использованием «роев» дешевых роботов (swarm space exploration system).

Вне «тематической» подборки в январском номере опубликованы две больших статьи. Авторами статьи «Автоматизация управления выбросами углекислого газа из зданий» («Automating a Building’s Carbon Management») являются Гита Тиагараджан, Венкатеш Саранган, Рамасубраманьян Сурианараян, Прагатичитра Сетанарам, Ананд Сивасубраманьян и Авинаш Егинараян (Geetha Thiagarajan, Venkatesh Sarangan, Ramasubramanian Suriyanarayanan, Pragathichitra Sethuraman, TCS Innovation Laboratories, Anand Sivasubramaniam, Pennsylvania State University, Avinash Yegyanarayanan, Tata Consultancy Services).

В мире проявляется все большая обеспокоенность по поводу потребления энергии, и лица, принимающие решения в области распределения ресурсов, должны стремиться к применению экологически выгодных, или экологически чистых (green) решений в системах управления. Двумя основными проблемами являются потребление энергии и выброс углекислого газа, и хотя у углеродистого следа (carbon footprint) имеется несколько компонентов, наибольший вред в обеих категориях наносят здания. По данным Совета по экологически чистому строительству США (Green Building Council, www.usgbc.org) здания потребляют около 72% от общего ресурса электроэнергии и выбрасывают 39% от общего объема выброса парникового газа.

Для определения воздействия здания на окружающую среду и сокращения его углеродистого следа менеджеры должны тщательно отслеживать основные источники парникового газа в здании. В настоящее время такой мониторинг состоит в организации периодических проверок для оценки уровней потребления ресурсов и выброса углекислого газа в зданиях, на основе которой затем вырабатываются рекомендации.

Авторы полагают, что у такого подхода имеются серьезные недостатки. Углеродистый след здания возникает в результате сложного взаимодействия его структурных и инфраструктурных характеристик, бизнес-процессов и особенностей эксплуатации, погодных условий, источников энергии, поведения обслуживающего персонала и нормативных актов. Более эффективный подход состоит в непрерывном отслеживании этих влияющих факторов и последующей перестройке рекомендаций с использованием реалистичного представления использования энергии и выброса парникового газа.

Непрерывный мониторинг, выполняемый вручную, может оказаться трудоемким, чреватым ошибками и дорогостоящим, поэтому для управления выбросами углекислого газа имеет смысл применять информационную технологию (ИТ). Основанные на ИТ экологически чистые решения не только масштабируются при росте размеров зданий, но также позволяют не отставать от их эксплуатационной динамики. Кроме того, ИТ позволяет инкапсулировать и воспроизводить наилучшие методы создания и применения экологически чистых решений, так что даже на объектах с недостаточно опытным персоналом можно успешно использовать качественное управление выбросами углекислого газа. Наконец, поскольку ИТ уже применяется в системах, имеющих отношение к выбросу парникового газа предприятиями, таких как корпоративные системы планирования ресурсов (enterprise resource planning) или управления потоками работ (workflow), разработку ИТ-систем для управления выбросами парникового газа не обязательно начинать с нуля. В ИТ имеется прочная основа стандартизации и построения распределенных сетевых систем, которую можно успешно применять в области управления зданиями.

На основе использования возможностей ИТ авторы разработали ИТ-инфраструктуру ECView (Energy and Carbon View), помогающую менеджерам находить и использовать решения, сокращающие углеродистый след зданий. Для проверки возможностей ECView система в течение года использовалась для непрерывного мониторинга и анализа углеродистого следа в офисном здании компании Tata Consultancy Services (TCS). На основе полученных данных были установлены пути к сокращению углеродистого следа здания TCS. Некоторые из выработанных стратегий вообще не требуют дополнительных капиталовложений.

Наконец, последняя большая статья номера представлена Анной Сквичиарини, Сатьей Девом Раджасекараном и Марко Касассой Монтом (Anna Squicciarini, Sathya Dev Rajasekaran, Pennsylvania State University, Marco Casassa Mont, HP Labs) и называется «Использование моделирования и симуляции для оценки рискозависимости предприятий от социальных сетей» («Using Modeling and Simulation to Evaluate Enterprises’ Risk Exposure to Social Networks»).

По мере роста распространенности социальных сетей внутри организационных и бизнес-сред служащие должны все более сознательно относиться к потенциальным рискам, относящимся к вопросам безопасности и бизнеса. Предприятия сталкиваются не только с падением производительности труда из-за траты времени служащими на активности в социальных сетях, но и с угрозами утечки информации, которая может негативно влиять на репутацию компаний, раскрывать нежелательные детали внутренней организации предприятий или даже напрямую порочить организацию, в которой работают служащие.

Хотя социальные сети делают доступной бизнес-информацию широкой аудитории, включающей заказчиков, конкурентов по бизнесу и партнеров, к этой информации могут получить доступ и хакеры, что может привести к утрате конкурентных преимуществ и финансовым потерям. Риски атак на хранилища данных социальных сетей возрастают по мере роста доступности соответствующих инструментальных средств, таких как агрегаторы данных и средства их интеллектуального анализа.

Лица принимающие решения (начальники технологических, информационных служб и служб информационной безопасности) серьезно озабочены проблемами социальных сетей, и во многих компаниях это явление активно изучается для понимания возможных преимуществ и рисков. Компании могут использовать социальные сети как ресурс для изучения возможностей потенциальных служащих или рекламы своего бизнеса. Однако они также вынуждены изучать подходы, смягчающие потенциальные риски использования этих сетей.

К числу подобных очевидных мер относятся блокирование изобличенных сайтов, обновления политик безопасности для предотвращения неприемлемого использования социальных сетей и введение новых правил и руководств. Однако эти противодействующие подходы часто не дают должного эффекта, если руководство компании не понимает причины рисков и влияние вариантов противодействия им. Например, блокирование доступа к сайтам социальных сетей с офисных компьютеров позволяет сократить время, затрачиваемое служащими на активности в социальных сетях, но никак не влияет на служащих, работающих дома или использующих персональные устройства.

В существующих руководствах по безопасному поведению в социальных сетях часто просто предлагается руководствоваться здравым смыслом и следовать общим процедурам. Очевидно, что такие советы не могут предотвратить или смягчить возможные атаки. В традиционных методологиях оценки рисков (такие как ISO 2700x, http://www.iso.org/iso/catalogue_detail?csnumber=42103) обеспечиваются практические советы и предлагаются процессы оценки, основанные на соображениях безопасности. Однако эти рекомендации и руководства необходимо детализировать и увязать с проблематикой социальных сетей.

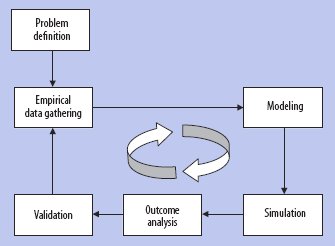

Авторы предлагают альтернативный подход, помогающий лицам, принимающим решения, размышлять об использовании социальных сетей и связанных с этим рисках, а также выбирать варианты решений для смягчения рисков. В этом подходе применяются языки моделирования для представления процессов, пользователей и систем, имеющихся на предприятии, угрожающих сред, а также уместных контрольных пунктов безопасности. В системе также симулируются последствия возможных угроз и влияние применения различных типов контроля.

Обзор предлагаемой методологии. В число различных шагов методологии входят определение проблемы, сбор опытных данных, моделирование и симуляция, а также анализ и валидация результатов. Может потребоваться несколько итераций.